Мајкрософт денес тврди дека ги објавил „најспособните и најекономичните модели на мали јазици (SLM) достапни“, велејќи дека Phi-3 - третата итерација на неговото семејство Phi модели на мали јазици (SLM) - ги надминува моделите со споредлива големина и неколку поголеми.

Мал јазичен модел (SLM) е тип на ВИ модел кој е дизајниран да биде исклучително ефикасен во извршувањето на одредени задачи поврзани со јазикот. За разлика од големите јазични модели (LLM), кои се добро прилагодени за широк опсег на генерички задачи, SLM се изградени на помала база на податоци за да ги направат поефикасни и исплатливи за конкретни случаи на употреба.

Phi-3 доаѓа во различни верзии, објасни Мајкрософт, а најмал е Phi-3 Mini, модел од 3.8 милијарди параметри обучен на 3.3 трилиони токени. И покрај неговата релативно мала големина - корпусот на Лама-3 тежи преку 15 трилиони токени податоци - Phi-3 Mini сè уште е способен да ракува со 128K токени на контекст. Ова го прави споредлив со GPT-4 и ги победува Llama-3 и Mistral Large во однос на токен капацитет.

Со други зборови, џиновите на вештачката интелигенција како Llama-3 на Meta.ai и Mistral Large би можеле да пропаднат по долг разговор или да побараат многу пред овој лесен модел да почне да се бори.

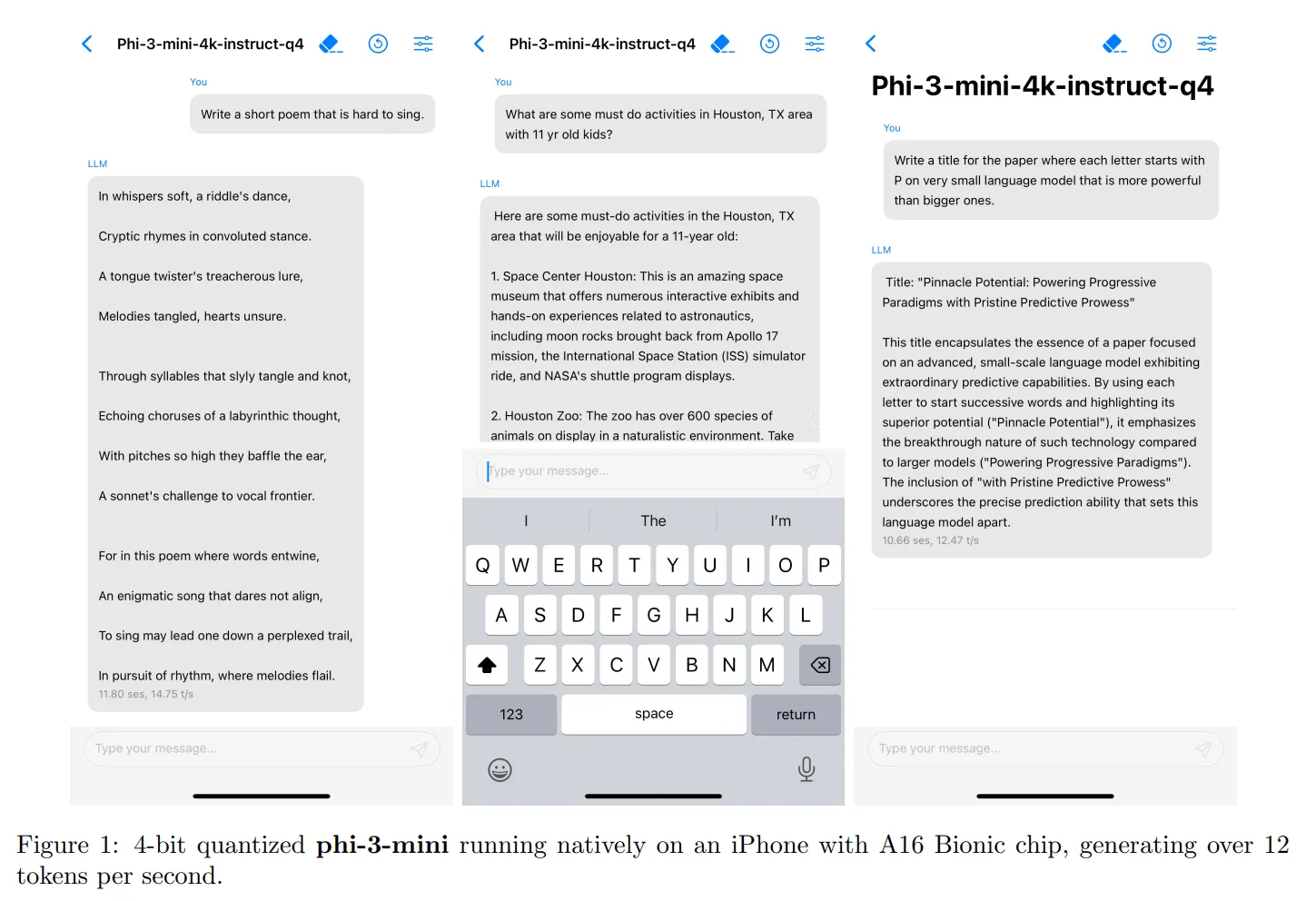

Една од најзначајните предности на Phi-3 Mini е неговата способност да се вклопи и да работи на типичен паметен телефон. Мајкрософт го тестираше моделот на iPhone 14 и работеше без никакви проблеми, генерирајќи 14 токени во секунда. Работењето на Phi-3 Mini бара само 1.8 GB VRAM, што го прави лесна и ефикасна алтернатива за корисници со пофокусирани барања.

Иако Phi-3 Mini можеби не е толку погоден за кодери од висока класа или луѓе со широки барања, тој може да биде ефикасна алтернатива за корисници со специфични потреби. На пример, стартапите на кои им е потребен chatbot или луѓе кои користат LLM за анализа на податоци може да користат Phi-3 Mini за задачи како организација на податоци, извлекување информации, правење математичко расудување и градење агенти. Ако на моделот му се даде пристап до интернет, тој може да стане прилично моќен, компензирајќи го недостатокот на способности со информации во реално време.

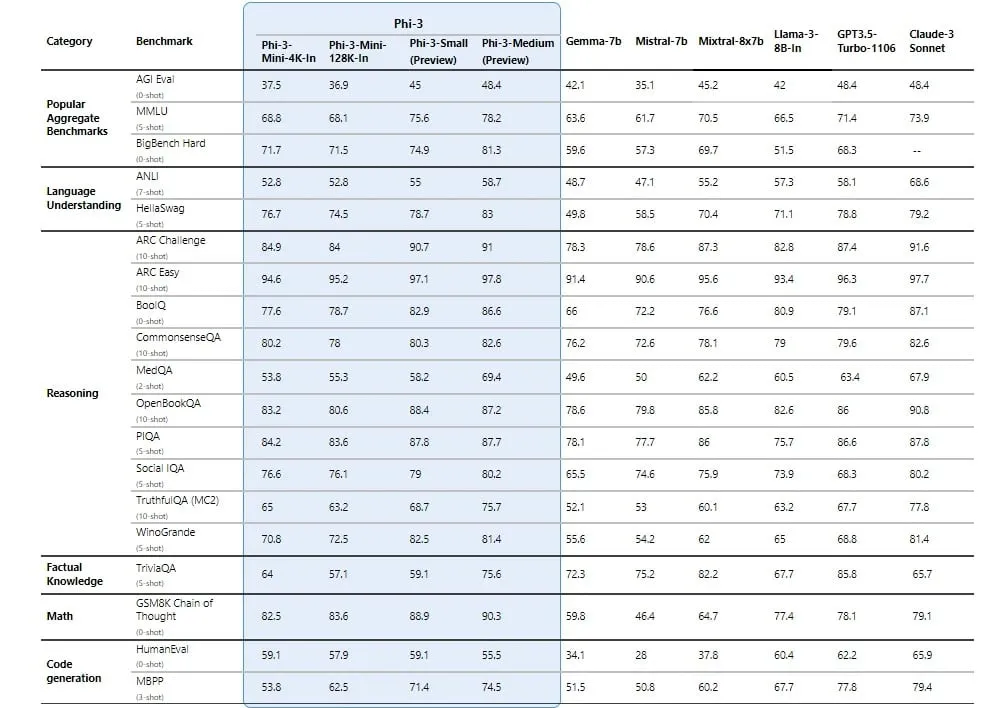

Phi-3 Mini постигнува високи резултати од тестовите поради фокусирањето на Мајкрософт на средување на неговата база на податоци со најкорисните можни информации. Пошироката фамилија Phi, всушност, не е добра за задачи кои бараат фактичко знаење, но високите вештини за расудување ги ставаат над главните конкуренти. Phi-3 Medium (модел со параметри со 14 милијарди) постојано ги надминува моќните LLM како GPT-3.5 - LLM што ја напојува бесплатната верзија на ChatGPT - и верзијата Mini ги надминува моќните модели како Mixtral-8x7B во повеќето синтетички репери.

Сепак, вреди да се напомене дека Phi-3 не е со отворен код како неговиот претходник, Phi-2. Наместо тоа, тоа е отворен модел, што значи дека е достапен и достапен за употреба, но го нема истото лиценцирање со отворен код како Phi-2, што овозможува поширока употреба и комерцијални апликации.

Во следните недели, Мајкрософт соопшти дека ќе објави повеќе модели од семејството Phi-3, вклучувајќи го и Phi-3 Small (7 милијарди параметри) и гореспоменатиот Phi-3 Medium.

Мајкрософт го направи Phi-3 Mini достапен на Azure AI Studio, Hugging Face и Ollama. Моделот е подесен со инструкции и оптимизиран за ONNX Runtime со поддршка за Windows DirectML, како и поддршка за меѓуплатформи на различни графички процесори, процесори, па дури и мобилен хардвер.

Останете на врвот на крипто вестите, добивајте дневни ажурирања во вашето сандаче.

Извор: https://decrypt.co/227974/microsoft-phi-3-mini-small-ai-language-model